Filosofie umělé inteligence

Filosofie umělé inteligence (UI) je odvětví filosofie, které se pokouší odpovědět na otázky jako:[1]

- Jaká je podstata inteligence? Může stroj plně nahradit uvažování lidské mysli?

- Je podstata počítače a lidského mozku stejná? Jaké metody využívá lidský mozek k vytvoření vědomí (nebo alespoň jeho iluze)?

- Může mít stroj mysl, duševní stavy a vědomí, podobné těm lidským? Může stroj cítit?

Tyto tři otázky odrážejí rozdílné zájmy vědců, zabývajících se umělou inteligencí: lingvistiku, kognitivní vědu a filosofii. Vědecká odpověď na tyto otázky plně závisí na užité definici "inteligence", "vědomí" a "stroje".

Mezi některé z hlavních postojů ve filozofii umělé inteligence patří:

- Turingova "zdvořilá úmluva": "Pokud se stroj chová stejně inteligentně jako lidská bytost, pak je stejně inteligentní jako lidské bytosti."[2]

- Dartmouthův návrh: "Každé hledisko učení nebo jakýkoliv jiný prvek inteligence může být tak přesně popsán, že stroj je schopen ho simulovat."[3]

- Hypotéza fyzického systému symbolů Newella a Simona: "Fyzický systém symbolů má všechny nutné a dostatečné prostředky pro obecnou činnost inteligence."[4]

- Argument čínského pokoje Johna Searle: "Ideálně naprogramovaný počítač se správnými vstupy a výstupy by měl mysl nerozlišitelnou od té lidské."[5]

- Hobbesův mechanismus: "Rozum není víc, než počítání."[6]

Zpracování informace lidským intelektem a počítačem

Tento odstavec se týká nápodoby vnějších projevů lidské inteligentní činnosti, nikoli modelování funkce struktur lidského mozku. Inteligentní lidská činnost je produktem procesů lidské psýchy, tedy procesů reálného světa. Imitující zařízení – počítač je exaktní stroj ze světa exaktního (exaktní věda, exaktní stroje, exaktní hry …). Jsou to dva rozdílné světy, s rozdílnými principy i možnostmi, avšak existuje jistá styčná oblast, v níž exaktní svět může modelovat reálný svět, a tak modelovat vnějškové projevy inteligentní lidské činnosti.

Styčná oblast modelování inteligentní lidské činnosti a možností exaktních strojů

Nalézt onu styčnou oblast znamená, nalézt takový model dané části reálného světa, který náleží do exaktního světa. Modelovat reálný svět tj. vytvořit jeho znalostní – kognitivní model tak, aby tento model byl součástí exaktního světa, je úloha vyřešená již exaktní vědou a je tak společná výše uvedenému přístupu umělé inteligence. Aby exaktní věda byla exaktní, musí být založena: zaprvé na exaktním poznání reálného světa (opuštěním vágnosti v úloze filtru poznání) a zadruhé na exaktním zápisu poznaného (zákazem vnitřní vágnosti interpretace všech jazykových konstrukcí použitého jazyka), a tak i exaktním sdělování poznaného.[7]. Exaktní věda je abstraktní konstrukcí, kdy reálný svět není poznáván přirozeným lidským způsobem (vágně), ale speciálně tvořenými prostředníky, veličinami a parametry . Jsou jistými manifestacemi reálného světa, či sondami do reálného světa. Znalosti o reálném světě (rozpoznané zákonitosti přírody) jsou pak zapsány matematickým jazykem jako vztahy mezi veličinami a parametry. Takto je vymezen způsob získávání informace o reálném světě (poznání) i charakter získaných informací. Totéž tedy musí platit pro umělou inteligenci. Jinými slovy, místo inherentně vágních znalostí získaných přirozeným lidským poznáním, lze v umělé inteligenci pracovat pouze se znalostmi získanými Newtonovým diskrétním filtrem exaktních věd. Jazykem reprezentujícím znalosti, musí být umělý formální jazyk, vyznačující se exaktní (tj. bez vnitřní vágnosti, tedy bez jakýchkoli pochyb) interpretací všech jazykových konstrukcí (matematika, formální logiky, programovací jazyky).

Exaktní a vágní znalosti

Mezi znalostmi získanými přirozeným poznáním a znalostmi získanými poznáním metodou exaktních věd, je kvalitativní propast. V prvém případě se na svět díváme filtrem vágnosti[8], v druhém případě Newtonovým filtrem „dírkovaným“, dírkami „vidíme“ veličiny a parametry - elementární manifestace reálného světa a vztahy mezi nimi, a nic jiného. Newton „digitalizoval“ přirozený vágní pohled člověka na reálný svět. Inherentně vágní znalosti získané přirozeným poznáním lze sdělovat (reprezentovat, popsat) jen a jen neformálním jazykem, nejčastěji přirozeným. Znalosti získané umělým poznáním lze reprezentovat umělým formálním jazykem (matematika, logika, programovací jazyky)[9],[7]. Jelikož vágnost přirozeného jazyka je především vnitřní a to i u kvantifikátorů, a vnitřní vágnost umělého formálního jazyka musí být vždy nulová, platí zde to, co bylo řečeno v heslech Vágnost a Exaktní věda, a to, že požadujeme-li exaktní poznatky zapsatelné umělým formálním jazykem, musí tyto znalosti být získány Newtonovým exaktním umělým poznáním. Nelze inherentně vágní znalosti získané přirozeným lidským poznáním, kde je filtrem poznáním vágnost, dodatečně převést na exaktní znalosti, tedy zbavit je inherentní vnitřní vágnosti, a tak dodatečně zkvalitnit informaci. Hledaná styčná oblast je tedy určena zaprvé typem znalostí a zadruhé typem použitého jazyka. Znalosti musí být získány umělým newtonovským poznáním, jazyk musí být umělý formální jazyk, u nějž interpretace je vždy exaktní, tedy bez vnitřní vágnosti.

Paralela lidského myšlení v exaktním světě

Cesta modelování vnitropsychických procesů exaktním strojem – počítačem není možná, nejen z důvodů, že tyto procesy jsou nedostatečně poznány, ale zejména z principiálních důvodů. Tyto procesy jsou postaveny na inherentní vnitřní vágnosti, a ta je v exaktním světě zakázána[9]. Cesta modelování vnitropsychických procesů proto směřuje k modelování struktur lidského mozku započaté modelováním neuronových sítí. Modelování lidského uvažování počítačem se v umělé inteligenci proto zatím provádí jinak, tak jak exaktní svět umožňuje. Odvozování (odhalování) nových informací z dosud existujících – výchozích, můžeme zahrnout do pojmu myšlení, a je chápáno jako inteligentní činnost člověka. V exaktním světě rovněž existuje odvozování čili inference, kdy z výchozích znalostí jsou získány - odhaleny znalosti dosud skryté. Tuto inferenci používá matematika a exaktní věda, a jako paralelu lidského myšlení, ji používá umělá inteligence. V exaktním světě se proces inference (odvozování – manipulace se symboly) děje na základě formální složky jazyka, které říkáme syntaktická složka jazyka (a inferenci se říká formální či syntaktická), viz příklad na stránce Vágnost. Sémantická (významová) složka jazyka se v tomto procesu neuvažuje, není zde žádný činitel, který by toho byl schopen.[7] Významovou složku přiřadí lidský subjekt až výsledné formě, někdy však z důvodů kontroly (odlaďování) správnosti i mezivýsledku, tedy zase odpovídající formě. Nástrojem pro odvozování je umělý formální systém, což je umělý formální jazyk se zavedenou inferencí, obvykle definovanou množinou inferenčních pravidel a množinou výchozích jazykových forem – axiomů, kterým se přiřadí významy výchozích znalostí, jednoduchý příklad viz Exaktní věda), nebo[9] (příklad odvození relativistických vztahů). Je nutno zdůraznit, že s výše vytyčenou styčnou oblastí, koresponduje požadavek na použití výhradně umělého formálního jazyka, a tak i umělého formálního systému, a tak tedy požadavek exaktní interpretace všech použitých jazykových konstrukcí. Toto je podmínka nutná pro ustavení umělého formálního jazyka a pro princip fungování formální inference, tedy i pro tzv. manipulaci se symboly. Formální inference se odehrává v jednotlivých krocích probíhajících ve vhodné posloupnosti v čase, jedná se tedy o pohyb. Hybatelem může obecně být pouze nějaký vnější činitel, tedy informace nepatřící do umělého formálního systému. Říkáme jí metainformace nebo metaznalosti. Představují strategii zmíněného pohybu, třeba reakce na tahy protihráče nějaké exaktníhry, na příklad šachu. Formální inference může mít mnoho podob, podle typu použitého formálního jazyka nesoucího – reprezentujícího znalosti.

Reprezentace znalostí

Reprezentace znalostí je schopnost jazyka (vyjadřovací síla) popisovat – reprezentovat jistou třídu znalostí. Základní klasifikací těchto tříd je způsob (filtr) poznání, kterým byly znalosti získány. Přirozené poznání používá jako filtr poznání vágnost a získané znalosti jsou inherentně vágní (Bertrand Russell)[8]. Odpovídající jazyk musí být rovněž inherentně vágní, tedy s vnitřní vágností interpretace, jazyk neformální, nejčastěji přirozený. Umělé poznání exaktních věd užívá diskrétní filtr Newtonův, získané znalosti jsou exaktní . Odpovídající jazyk je umělý formální jazyk s exaktní interpretací všech svých jazykových konstrukcí, tedy s nulovou vnitřní vágností oné interpretace. Jiné, dalším způsobem vytyčené třídy znalostí, vyžadující specifické formy reprezentujících jazyků, obvykle související s typem úloh. Jedny typy úloh vyžadují na příklad matematickou algebru, jiné třeba některou z formálních logik apod. Pokud jsou formální jazyky schopny modelovat vágnost (např. mírou důvěry, fuzzy nástroji, stochasticky), jedná se vždy jen o vágnost vnější, vnitřní vágnost tj. vágnost interpretace musí být u formálních jazyků vždy nulová.

Může stroj vykazovat známky obecné inteligence?

Je možné vytvořit stroj, který může vyřešit všechny problémy, které lidé řeší pomocí své inteligence? Tato otázka by mohla určit budoucí směr výzkumu UI. Zároveň se tato otázka týká pouze chování strojů a ignoruje otázky zájmu psychologů, kognitivních vědců a filozofů; abychom byli schopni tuto otázku zodpovědět nezáleží na tom, zda stroj skutečně myslí, pro naše účely je postačující, bude-li se pouze navenek chovat jako myslící bytost.[10]

V současnosti nejrozšířenější postoj většiny odborníků na UI souzní s návrhem prohlášení z Dartmouthské Konference z roku 1956:

- Každý aspekt učení nebo jakékoliv jiné funkce inteligence může být popsán tak přesně, že ji stroj může simulovat.[3]

Argumenty proti této premise se snaží nalézt limity funkčního systému umělé inteligence oproti mechanismům lidského myšlení.

První krok k zodpovězení otázky je jasně definovat pojem "inteligence".

Inteligence

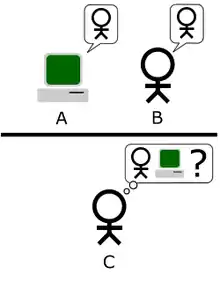

Turingův test

Alan Turing redukoval problém inteligence ve své známé studii z roku 1950[11] na jednoduchou schopnost vést konverzaci. Bereme-li jako klíčovou složku lidské inteligence schopnost myslet, není skutečně její funkce po vzoru Descartova dualistického konceptu "ducha ve stroji"[12] či Hodgsonovy černé skříňky[13] ničím víc, než soubor interakcí s vnějším okolím.

Turing svůj model navrhl pomocí myšlenkového experimentu, ve kterém, podobně jako v argumentu čínského pokoje, počítač komunikuje korespondenčně tak, jako člověk, a uzavírá, že všechny rozdíly mezi hypotetickým systémem myšlení počítače, by mohly být známými informačními metodami smazány.

Poprvé byl Turingův test v praxi ozkoušen projektem ELIZA (1960). Moderní verzí Turingova myšlenkového experimentu jsou on-line programy, které rozhovor napodobují s dobrou přesností, využívají ale buď předchozích odpovědí jiných uživatelů (např. Cleverbot), nebo jednoduše položí otázku o podmětu předchozí repliky uživatele (ELIZA). Je ale důležité poznamenat, že i pokud předchozí uživatelé slouží pouze jako učitelé komunikačního robota, nesplňují podmínku definice schopnosti vytvářet vlastní myšlenkovou úvahu - jejich "myšlení" není celistvý systém.

Turing poznamenává, že nikdo nezpochybňuje, že lidé dokáží myslet, přestože nemusíme rozumět podstatě "myšlení". Turing proto říká, že bychom se měli namísto debat nad definicemi soustředit na tuto jednoduchou "zdvořilou konvenci":

- Pokud se stroj chová tak inteligentně, jako člověk, pak je stejně inteligentní jako lidské bytosti.

Kritici Turingova testu namítají, že je antropomorfní. Pokud je naším konečným cílem vytvořit stroje, které jsou více inteligentní než lidé, proč bychom měli trvat na tom, že naše stroje se musí úzce podobat lidem? Russell a Norvig napsali, že "učební texty letového inženýrství nedefinují cíle svého oboru jako stroje, 'které dokáží létat tak, že se podobají holubům natolik, že jejich létání není odlišitelné od létání holubů'"[14]

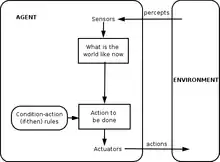

Definice inteligentního agenta

Nejnovější výzkum UI definuje inteligenci za pomoci tzv. inteligentních agentů. "Agent" je něco, co vnímá a reaguje na své prostředí. Míra zásahu do prostředí následně definuje úspěch pro agenta.[15]

- Pokud se agent chová tak, aby maximalizoval očekávanou hodnotu zásahu do prostředí na základě minulých zkušeností a znalostí, pak je inteligentní.[16]

Definice, jako je tato, se snaží zachytit podstatu inteligence. Mají tu výhodu, že na rozdíl od Turingova testu se nesnaží zachytit podstatu inteligence v kontextu lidských rysů, čímž eliminují lidské rysy, které by mohly souviset s tím, co si spojujeme s inteligencí jen vlivem lidské evoluce. Mnoho nevýhod této definice ale plyne z jejího striktního rozdělení mezi myslícím a nemyslícím. Proto definice přisuzuje i termostatu primitivní inteligenci.[17]

Za pohled na vědomí v podobě určitých „stupňů“ (umělé bytí, postoj, podle kterého nelze vytyčit jasnou hranici mezi vědomým a nevědomým) se staví i J. Walmsley ve své knize Mind and Machine. Uvádí zde řadu dřívějších myšlenkových experimentů (Pylshyn 1980, Chalmers 1995), které zkoumaly, ve kterém momentě by v případě nahrazování neuronu za neuronem transistory se stejnou funkcí, ztratil mozek svou funkci „vědomí“. Tento pohled potvrzuje i fakt, že ani při pohledu na různé stupně poškození mozku nevidíme žádný důležitý „práh“, který by určoval, nakolik člověk vykazuje známky toho, co nazýváme vědomím.

Mozek může být simulovaný

Hubert Dreyfus tento argument popisuje následovně: "V případě, že se nervový systém řídí zákony fyziky a chemie, čemuž nemáme žádný důvod nevěřit, pak bychom měli být schopni reprodukovat chování nervového systému s nějakým fyzickým zařízením."[18]

Tento argument byl poprvé představen již v roce 1943,[19] roku 1988 jej rozšířil Hans Moravec představením svého ("Moravcova") paradoxu (umíme vytvářet počítače, které porazí i nejlepší šachisty, ale vytvořit stroj, který napodobuje neuromotorický aparát pětiletého dítěte (např. dovednost chycení míče) je dosud neproveditelným úkolem)[20] a nyní je spojen především s futuristou Rayem Kurzweilem,[21] který odhaduje, že počítače budou schopny simulovat mozek kolem roku 2029. Počítačová simulace, ne v reálném čase, byla ale poprvé provedena na modelu thalamokortikálního systému v životní velikosti(1011 neuronů) již v roce 2005[22]. Z hlediska technologie vlastně chybí současným technologiím především výpočetní prostor, jedna sekunda simulace mozku z roku 2005 zabrala 50 dní (viz také[23]).

Argument v určité podobě představil také David Eaglemen v pořadu Cesta do hlubin lidského mozku, ve kterém říká, že pokud lze fyzikální systém popsat omezeným množstvím dat, je v teorii možné vytvořit přesnou digitální kopii mozku jako program. Pokud by to, co určuje vědomí, byl skutečně pouhý systém se všemi svými prvky, měla by ona digitální kopie také prožívat totožně své vědomí (komputionalismus).[24] Komputalismus je forma fyzikalismu, moderního materialismu, který z fyzikální podstaty světa vysuzuje nejen, že vědomí je plně poznatelný koncept, ale také že mozek funguje jako počítač, na základě postupů, které bychom mohli rozepsat do dílčích algoritmů tak, jako počítačový program.

Proti tomuto argumentu se postavil Hubert Dreyfus či John Searle. (Dreyfus například popírá, že by bylo možné popisovat lidské chování deterministicky, na druhou stranu připouští, že naprogramovatelnost mozku z fyzikalismu přímo vyplývá)[25] Nicméně, Searle poukazuje na to, že v zásadě cokoli může být simulováno počítačem; jdeme-li do důsledku, jsou tedy všechny procesy ve vesmíru "výpočty", matematickými modely. "Chtěli jsme vědět, co odlišuje mysl od termostatu či jater," píše.[26] Proto by pouhé napodobování fungování mozku v dnešní době bylo jen doznáním, že jsme ve studiu inteligence a povaze mysli jen v počátcích.

Lidské myšlení je zpracování symbolů

V roce 1963 Allen Newell a Herbert A. Simon navrhli, že základním kamenem nejen lidské inteligence, ale i inteligence obecně, je práce se symboly. Názor vyjádřili následovně:

- Fyzický systém symbolů má potřebné a vystačující prostředky pro obecnou činnost inteligence.[4]

Tento výrok má široké důsledky: jednak z něho vyplývá, že symbolické myšlení je nutné pro vývoj inteligence a na sestavování "symbolů" - mentálních reprezentací je postaveno i samotné lidské myšlení, a že stroje mohou být inteligentní (protože manipulace se symboly je pro inteligenci vystačující).[27] Další verzi této pozice popsal filozof Hubert Dreyfus, který to nazývá "psychologickým předpokladem":

- Mysl může být chápána jako zařízení, které funguje na bity informací podle formálních pravidel.[28]

Rozdíl je obvykle mezi symboly na vysoké úrovni, které přímo korespondují s objekty ve světě, jako je <pes> a <ocas>, a složitějšími "symboly", které jsou přítomny v počítači jako neuronové sítě. Raný výzkum UI, známý jako "good old fashioned artificial intelligence" (GOFAI) - "stará dobrá umělá inteligence", se v pracích vědců, jakým byl např. John Haugland, zaměřoval na takové vysoké úrovně symbolů.[29]

Argumenty proti podmínce symbolického myšlení

Tyto argumenty ukazují, že lidské myšlení nespočívá (pouze) na vysoké úrovni zpracování symbolů (nejedná se o argumenty proti umělé inteligenci obecně, pouze proti významnosti zpracování symbolů).

Gödelovské anti-mechanistické argumenty

V roce 1931 Kurt Gödel dokázal svými větami o neúplnosti, že je vždy možné postavit "Gödelův výrok", který daný konzistentní formální systém logiky není schopen dokázat. Přestože je ale tento výrok pravdivý, není Gödelův výrok v daném systému dokazatelný. (Pravdivost konstruovaného Gödelova výroku je závislá na konzistenci daného systému; použití stejného algoritmu na mírně nekonzistentní systém, se bude zdát jako správné, ale bude ve skutečnosti tzv. falešným "Gödelovým výrokem".) Spekulovat pak lze o Gödelově domněnkách, že lidská mysl může nakonec správně zjistit pravdu nebo nepravdu jakéhokoli dobře podloženého matematického výroku, včetně Gödelova výroku, a to proto, že lidská mysl není redukovatelný mechanistický model. Za tento filozofický anti-mechanistický argument bojoval filozof John Lucas (od roku 1961) či fyzik Roger Penrose (od roku 1989).[30] Zastánci gödelovských anti-mechanistických argumentů proto často považují za nemožné postavit stroj, který by dokázal dokonale napodobovat činnost (idealizované racionální) lidské inteligence typu Turingova stroje (často rozšířeno na veškeré mechanické stroje).

Nicméně v současnosti (k roku 2015) panuje v akademické obci konsenzus, že lidské myšlení je nekonzistentní (nesplňuje podmínky oné racionální "mysli matematika"), a proto jako argument proti možnosti sestavení umělé inteligence není Gödelův teorém validní.[31][32][33]

Více pragmaticky se k věci staví Russell a Norvig. Poznamenávají, že Gödelův argument se vztahuje pouze na to, co může být teoreticky dokázáno, vzhledem k nekonečné kapacitě paměti a nekonečnému množství času. V praxi mají skutečné stroje ("včetně člověka") omezené zdroje a budou mít, stejně jako stoj, potíže s dokazováním mnoha vět. Zároveň ale není nutné dokázat všechno pro to, abychom se ukazovali jako inteligentní.[34]

Kritický pohled ke Gödelovým argumentům zaujímá i Douglas Hofstadter, ve svém díle Gödel, Escher, Bach: An Eternal Golden Braid. Uvádí, že tyto "Gödelovské výroky" se vždy vztahují k samotnému systému, Hofstadter to přirovnává k Epimenidovu paradoxu:[35]

- Lukáš nemůže potvrdit pravdivost tohoto tvrzení.[36]

Toto tvrzení je pravdivé, pokud ho nevysloví Lukáš. To ukazuje, že Lukáš podléhá stejným omezením (teorie vztahující na systém samotný), jako všichni lidé i stroje, a proto je argument nesmyslný.[37]

Dreyfus: Prvenství v nevědomosti

Hubert Dreyfus se zastával názoru, že systém lidského mozku nemůže být zachycen jako seznam formálních pravidel. Tvrdil, že lidská inteligence a znalost závisí v prvé řadě na nevědomých instinktech, spíše než vědomém manipulování se symboly.[38]

Právě Turing argument Huberta Dreyfuse využil ve své studii z roku 1950, jako podklad pro "argument z neformálního chování".[39] Nicméně Turing poznamenal, že jenom to, že neznáme pravidla, která řídí komplexní chování, nemusí znamenat, že tato pravidla neexistují. Napsal: "Nemůžeme tak snadno odolat myšlence, že zákony, podle kterých se řídí lidská mysl nelze zachytit. [...] Jediný způsob, jak můžeme nacházet zákony, je empirické pozorování a nikdo dosud v žádné oblasti neprovedl tolik výzkumu, aby mohl říct: 'Tak jsme hledali dost, nejsou tu žádné zákonitosti.'"[40]

Může stroj nabýt vědomí, duševních stavů a mysli?

To je filozofická otázka, vztahující se k problému jiných myslí a obtížnému problému vědomí. Otázka se točí kolem toho, co znamená pro filosofii koncept "silné UI" Johna Searleho.

- Fyzický systém symbolů může mít mysl a duševní stavy.[5]

Searle tuto pozici odlišuje od toho, co nazývá "slabá UI":

- Fyzický systém symbolů může jednat inteligentně.[5]

Následně Searle tvrdí, že i když budeme předpokládat, že máme počítačový program, který se chová jako lidská mysl, stále před námi bude otázka vědomí..[5]

Důležité je, že ani jedna z pozic, které Searle nastínil, neohrožuje výzkum UI, protože neodpovídá přímo na otázku "Může stroj vykazovat známky obecné inteligence?". Turing v odpovědi napsal: "Nepřeji si, aby vznikl dojem, že v podstatě vědomí nevidím žádnou záhadu... Nemyslím si ale, že odpověď musíme znát pro zodpovězení, jestli stroje mohou myslet."[41] Russell a Norvig se shodují, že: "většina výzkumníků UI bere slabou hypotézu UI za samozřejmost, nehledě na to, co předkládá silná hypotéza UI."[42]

Existuje několik vědců, kteří se domnívají, že vědomí je základním prvkem inteligence, jako Igor Aleksander, Stan Franklin, Ron Slunce, a Pentti Haikonen, přestože jejich definice "vědomí" je velmi blízko "inteligenci". (viz umělé vědomí.)

Searlův Čínský pokoj

Takzvaný argument čínského pokoje představil John Searle roku 1980 a dodnes hýbe debatou o umělé inteligenci. Searle svůj argument staví kolem hypotetického Turingova stroje, v tomto případě počítače, který je schopen dokonale plynule konverzovat v čínštině. Searleho stroj však nevyužívá dráty a tranzistory, je to stroj, který sestává z rodilého Čecha v zamčené čínské knihovně s lístečky popsanými jednoduchými pravidly jako "謝謝 => 不客氣" (díky => není zač). Pokud byste Čechovi pod dveřmi posílali čínské zprávy, mohl by vám odpovídat, přestože rozhodně neví, o čem mluví. Stroj samotný - zamčená knihovna - neumí čínsky. Proto, podle Searleho, nelze sestrojit fyzický systém symbolů, který by měl mysl, sebeuvědomění, vědomí, či mentální stavy.[43]

Přesto, podle Searleho, jeden takový existuje: lidský mozek. Searle prosazuje, že fyzický systém symbolů může mít vědomí pouze se "skutečnými fyzikálně-chemickými vlastnosti skutečných lidských mozků",[44] a že existují speciální "kauzální vlastnosti" mozku a neuronů, které vedou k vývoji mysli. V jeho slovech "mozek způsobuje mysl."[45]

Za to, abychom automaticky neodhazovali materiál lidského mozku jako potenciální ohnisko problému se postavila i filozofka Susan Schneider. Píše, že vzhledem k tomu, že uhlík (nejčastější prvek lidského těla) vytváří se svými stabilnějšími čtyřčetnými vazbami mnohem víc kombinací sloučenin, už jen jeho chemická povaha určuje, kde astrobiologové život mimo Zemi (a posléze potenciální evoluci vědomí) hledají. Podle Schneiderové bychom proto neměly hypotézy o tom, že fyzikální podstata mozku může hrát v existenci vědomí roli, tak snadno vyloučit.[46]

Podobné koncepty: Leibnizův mlýn, Davisovi zaměstnanci telekomunikací a Hlupák

Gottfried Leibniz učinil v podstatě stejný myšlenkový experiment jako Searle v roce 1714, s představou lidského mozku, který se rozpíná do velikosti mlýna, čímž se dostává, stejně jako čínský pokoj, na úroveň stroje (otázkou je, jestli pak neztrácí ony Searleho "fyzikálně-chemické vlastnosti lidského mozku").[47] V roce 1974 zveřejnil podobnou úvahu Lawrence Davis V jeho úvaze by fyzický systém symbolů představoval tým telefonních komunikací, který si jako celek není při rozdělené práci vědom, jak komunikace pokračuje se zákazníkem, přestože jí je schopen. Roku 1978 vztáhl Ned Block tuto představu na celý "čínský národ".[48]

Reakce na čínský pokoj

- Odpověď virtuální mysli[49] říká, že systém, včetně onoho Čecha, programu, pokoje a karet, je to, co rozumí čínsky. Searle tvrdí, že muž v místnosti je jediná věc, která by mohla "mít mysl" nebo "rozumět čínštině", ale řada filosofů s ním nesouhlasí. Namísto toho tvrdí, že je možné, aby součástí jednoho fyzického systému symbolů byly dvě mysli, podobně jako součástí počítače může být více podsystémů, které samy o sobě neslouží účelu. V alegorii s čínským pokojem by mohl Čech představovat program, nainstalovaný do předprogramovaného počítače.

- Problém rychlosti, síly a komplexity stroje:[50] Několik kritiků ukazuje na to, že Čechovi by pravděpodobně zabralo miliony let, než by byl schopen odpovědět na jednoduchou otázku, prohledávaje kartotéky astronomických rozměrů. Na druhou stranu tak, jako se v geometrii nepočítá úkol za možný, pokud k němu dospějeme nekonečně mnoho kroky, mohli by Searleho příznivci tento poznatek využít jako argument pro to, že lidská mysl skutečně operuje s něčím, co nelze sestrojit z drátů a cívek.

- Představa robota:[51] Možná paradox, který vidíme v představě vědomí pokoje, spočívá v lidské neschopnosti personifikovat si myslící systém bez očí a rukou. Hans Moravec píše: "Pokud bychom mohli vytvořit robota s programem "přemýšlení", nepotřebovali bychom už žádnou osobu, aby nám dále interpretovala jeho chování: bylo by to zřejmé z jeho interakcí s fyzickým světem."[52]

- Čínský pokoj jako simulátor mozku:[53] Co kdybychom si představili program, který simuluje sekvence nervových signálů skutečného mozku skutečného rodilého Číňana? Za takového předpokladu by muž v místnosti simuloval skutečný mozek. Je to sice variace odpovědi virtuální mysli, pokud si ale dokážeme připodobnit spolupracující synapse jako jednotlivé uzly systému, který Čínský pokoj využívá ke komunikaci, můžeme už jednoznačně říci, že kromě zamčeného muže je zde něco dalšího, co je schopno "rozumět čínštině".

- Epifenomenální odpověď:[54] Několik filosofů poukázalo na to, že Searleho hypotéza není víc, než jistá verze problému jiných myslí (není, jak dokázat, že druzí lidé mají také vědomí) aplikovaná na stroje. Protože je obtížné rozhodnout, zda jsou vůbec lidé "ve skutečnosti" vědomí, nemůžeme být překvapeni, že si můžeme lámat hlavu se stejnou otázkou pro stroje.

Studium vědomí

Důležitou otázkou, která by problém čínského pokoje do značné vyřešila je, zda "vědomí" (v Searleho pojetí) vůbec existuje. Searle tvrdí, že prožitek vědomí ze své podstaty nemůže být empiricky studován na strojích, tak jako na lidech a zvířatech. Daniel Dennett poukazuje na to, že přírodní výběr nemůže zachovat funkci zvíře, které nemá žádný vliv na jeho chování, a tedy vědomí (v Searleho pojetí) nemůže být produktem přirozeného výběru. Proto buďto vědomí přišlo z jiného zdroje, než je přirozený výběr, nebo platí hypotéza silné UI a vědomí může být detekováno pomocí vhodně navrženého Turingova testu.

Je myšlení víc než forma komputace?

Otázku možnosti uměle vytvořit vědomí můžeme obrátit: Existuje fundamentální rozdíl mezi lidským mozkem a strojem? Tato otázka nabyla na významu u před-osvíceneckých a osvíceneckých filosofů v podobě sporu mezi racionalismem a empirismem:

- Davida Hume poprvé představil myšlenku, že myšlení je "atomizovatelné" na několik základních emocí

- Pro Thomase Hobbese myšlení není "nic víc, než kalkulování" [s obecnými jmény a myšlenkami]

- Podle Immanuela Kanta je veškerá zkušenost něčím kontrolovaným formálními pravidly[55]

Hilary Putnam a Jerry Fodor na myšlenky o algoritimizaci myšlení navázali v komputační teorii mysli, podle které lze vztah mezi myslí a mozkem přirovnat ke vztahu mezi běžícím programem a hardwarem, a myšlení je tedy povahy čistě fyzické.[56]

Další související otázky

Alan Turing poznamenal, že je i v současné popkultuře hluboce zakořeněno mnoho představ o myšlení, které jsou spojeny výhradně s člověkem.

Lidé často tvrdí, že stroj nikdy nebude laskavý, vynalézavý, krásný, přátelský, nikdy nebude jednat z popudu, nebude mít smysl pro humor, nebude schopen odlišit dobré od zlého, dělat chyby, zamilovat se, užívat si jahody se smetanou, přimět někoho ho milovat, učit se ze zkušenosti, nacházet "správná" slova, myslet sám na sebe, mít tak rozmanité chování jako člověk či vytvořit něco opravdu nového.

Turing tvrdí, že tyto námitky jsou často založeny na naivních předpokladech o univerzálnosti stroje, nebo jsou "převlečené argumenty vědomí". Napsání programu s alespoň jednou z těchto vlastností "nebude dělat velký dojem."[57] Zároveň se ale všechny tyto argumenty dotýkají základního předpokladu vytvoření skutečné UI. Tato úvaha zahrnuje několik podobných otázek:

Může mít stroj emoce?

Pokud definujeme "emoce" pouze z hlediska jejich vlivu na chování nebo na to, jakou funkci mají uvnitř organismu, pak se dostaneme k pragmatickému vědeckému pohledu na emoce, jako na kognitivní nástroj inteligentního agenta pro maximalizaci své efektivity. Pokud by emoce neznamenaly nic "víc", Hans Moravec věří, že by "roboti obecně byli pevně emocionálně zakotveni ve víře, že jsou dobrými lidmi".[58]

Koneckonců, emoce jsou v důsledku také jen produktem dlouhé práce evoluce. Strach nás nutí jednat hbitě, úzkost burcuje naši ostražitost. A empatie je nezbytnou součástí dobré interakce člověka s počítačem. Moravec proto vyvozuje, že roboti "budou usilovat o to, potěšit člověka se zdánlivě nesobeckým úmyslem, vnitřně však budou motivováni silnou pozitivní zpětnou vazbou. To bychom mohli interpretovat jako určitý druh lásky."[58]

Emoce nicméně mohou být také definovány z pohledu své subjektivní kvality jako čistý prožitek. Otázka, je-li stroj schopen skutečně cítit emoci, či jestli by se pouze choval jako někdo, kdo emoce cítí, je ale jen jiná formulace otázky "Může mít stroj vědomí?".[41]

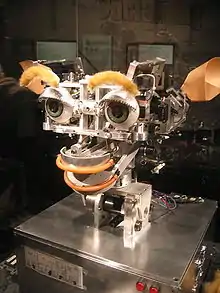

Problém vykazování emocí by mohl souviset i se schopnostmi přijímat subjektivní informace - to však nemusí při bližším zkoumání podle některých výzkumníků znamenat více, než vztahovat příchozí informace sám k sobě. Co se týče vnímání emocí, v současnosti existují počítačové programy, které dokáží rozpoznat lidské emoce z videozáznamu, často včetně lhaní díky lidským podvědomým cukům v obličeji v řádech milisekund. V opačném směru (viz robot Kismet) však vývoj dosud do takových rovin nepostoupil.[59]

Může si být stroj vědom sebe sama?

Vědomí vlastní existence a vlastního vědomí se jako znak člověka dostal do filozofie zejména vlivem science-fiction. Turing podobné otázky redukuje do jediné: "Může být stroj objektem vlastních myšlenek?" Pokud nebereme v úvahu širší souvislosti, jako je vědomí, svobodná vůle či náboženské cítění, je zřejmé, že program typu debugger může být předmětem vlastních komputací stejně, jako cokoli jiného.[57]

Může být stroj originální a kreativní?

Otázka kreativity je v podstatě klíčová pro filosofii umění: "Mohou umění vytvářet šimpanzi?", " Nakolik je fotografie uměním?"," Mohli bychom náhodně vygenerovaný obraz považovat za umělecký?". Alan Turing otázku výrazně zjednodušil: "Může nás stroj překvapit?" - otázka pro zkušeného programátora takřka řečnická.[60]

Turing poznamenává, že s dostatečnou kapacitou paměti má počítač mnoho možností, jak se zachovat.[61] Proto musí být pro počítač triviální kombinovat "myšlenky" do nových konstruktů.(Příkladem může být již první pokus o vytvoření programu pro vědecký výzkum roku 1977, Automated Mathematician[62] Douglase Lenata)

Roku 2009 sestrojili vědci z Aberystwyth University in Wales a U.K's University of Cambridge robota, který měl být vůbec prvním strojem schopným nezávisle přicházet na nové vědecké poznatky.[63] V roce 2009 také výzkumníci z Cornellu vyvinuli program Eureqa, který extrapoluje rovnice tak, aby seděla se zadanými daty (například dovede vyvodit zákony pohybu z rovnice pro pohyb kyvadla).

Může být stroj benevolentní či nepřátelský?

Pomineme-li otázku vědomí, sestává tento problém z jediné otázky, kterou se budou muset zákonodárci v budoucnu zabývat: "Může se umělá inteligence stát pro lidi nebezpečnou?".[41]

Otázka je především studována s ohledem na potenciál inteligentní, plně autonomní umělé inteligence. Autor sci-fi a profesor informačních technologií Vernor Vinge upozorňuje hlavně na riziko, které v budoucnosti budou představovat počítače milionkrát inteligentnější, než lidé. Tomuto bodu říká "The Singularity."[64][65] Tato hrozba je diskutovaná filosofií známou jako singularitarianismus.

Roku 2009 proběhla diskuze tohoto problému na konferenci technologických expertů. Shodli se na tom, že jistý stupeň autonomie mají stroje už dnes, dokonce se na ně spoléháme, když nezávisle vytyčují cíle vojenských útoků. Vyznělo také, že nemusí být nebezpečná samotná umělá inteligence, nějakou evolucí procházejí dnes i například počítačové viry. Vědomí sebe sama podle nich zůstane světovou hrozbou jen ve science-fiction, věří ale, že se spojeným globálním počítačovým systémem přichází jiné, podstatnější problémy.[64]

Někteří experti a akademici ale vyzdvihnuli problém užívání robotů ve vojenství.[66] Americká vojenská flotila již předtím ale vydala prohlášení, podle kterého by měla být s rostoucí komplexitou počítačových systémů, věnována větší pozornost tomu, jak jsou vytvářena zodpovědná rozhodnutí.[67][68]

Sam Harris na TEDSummitu zmínil, že celý problém kvůli své zvědavosti bereme na příliš lehkou váhu (jak ukazuje úspěšnost apokalyptických filmů o robotech) a největším problémem je, že v současnosti si škálu inteligence představujeme příliš antropocentricky a možnosti vyšší inteligence nemusíme svým vnímáním chápat. V případě, že by umělá inteligence takových stupňů inteligence dosáhla, mohla by nás začít brát tak, jako my bereme mravence - ne že by se nás pokoušeli vyhladit, ale neotáleli by nás zadržet tam, kde bychom jim křížili cestu.

Sam Harris také poukazuje na to, že i kdyby byla zkonstruovaná inteligence jen tak inteligentní jako průměrný vědec, dokázal by svou vysokou výpočetní rychlostí oproti biochemických procesům mozku prostudovat nepřebratelněji více. Obrovskou výhodu by také získaly země, které by umělou inteligenci mohly využít jako prostředek boje, proto by podle něj příchod umělé inteligence mohl přinést stejné socio-politické problémy jako velké sociální rozdíly a nezaměstnanost. Podle Sama Harisse bychom měli, podobně jako tak učinily USA ve čtyřicátých letech v rámci Projektu Manhattan, sestavit tým nejlepších expertů, který by se rizika UI snažil rozebrat, protože zatím nemůžeme vědět ani za jak dlouho nás tyto rizika mohou ohrozit, ani jak bychom se jim měli bránit.[69]

Může mít stroj duši?

Nakonec je zde otázka, možná mimo dosah exaktních studií: "Je lidské myšlení součástí nefyzické duše?" I tomuto "teologickému argumentu" věnoval Alan Turing odstavec své studie:[70]

Ve snaze sestrojit takové stroje bychom neměli začít slepě uzurpovat Jeho moc tvořit duše, stejně tak jako naši schopnost plodit děti, v každém případě jsme ale maximálně nástroji Jeho vůle vytvářet těla pro (nesmrtelné) duše, které již vytvořil.

Otázky pro budoucí výzkum

John McCarthy, tvůrce programovacího jazyka pro umělou inteligenci LISP a samotného konceptu UI říká, že někteří filozofové UI budou ještě dále vést spory o tom, je-li...

- ...umělá inteligence nedosažitelná? (Dreyfus),

- ...umělá inteligence nemorální? (Weizenbaum),

- ...samotný koncept umělé inteligence křehký? (Searle).

Související články

Literatura

- Křemen, J.: Nový pohled na možnosti automatizovaného (počítačového) odvozování. Slaboproudý obzor. Roč. 68 (2013), č. 1., str. 7 – 11. Nyní ke stažení na: http://www.slaboproudyobzor.cz/files%5B%5D

Poznámky

Reference

V tomto článku byl použit překlad textu z článku Philosophy of artificial intelligence na anglické Wikipedii.

- Russell & Norvig 2003, p. 947 define the philosophy of AI as consisting of the first two questions, and the additional question of the ethics of artificial intelligence.

- This is a paraphrase of the essential point of the Turing test.

- McCarthy et al. 1955.

- Newell & Simon 1976 and Russell & Norvig 2003, p. 18

- This version is from Searle (1999), and is also quoted in Dennett 1991, p. 435.

- Hobbes 1651, chpt. 5

- Křemen, J.: Nový pohled na možnosti automatizovaného (počítačového) odvozování.

- Russell B.: Vagueness

- Křemen, J.: Modely a systémy

- See Russell & Norvig 2003, p. 3, where they make the distinction between acting rationally and being rational, and define AI as the study of the former.

- Turing 1950 and see Russell & Norvig 2003, p. 948, where they call his paper "famous" and write "Turing examined a wide variety of possible objections to the possibility of intelligent machines, including virtually all of those that have been raised in the half century since his paper appeared."

- WALMSLEY, J. Mind and Machine. [s.l.]: Springer 233 s. Dostupné online. ISBN 9781137283429. (anglicky) Google-Books-ID: O3cYDAAAQBAJ.

- Hodgson’s Black Box | Naturalism.org. www.naturalism.org [online]. [cit. 2016-11-12]. Dostupné online.

- Russell & Norvig 2003, p. 3

- Russell & Norvig 2003, pp. 4–5, 32, 35, 36 and 56

- Russell and Norvig would prefer the word "rational" to "intelligent".

- Russell & Norvig (2003, pp. 48–52) consider a thermostat a simple form of intelligent agent, known as a reflex agent.

- Dreyfus 1972, p. 106

- Pitts & McCullough 1943

- Moravec 1988

- Kurzweil 2005, p. 262.

- Eugene Izhikevich (2005-10-27).

- vesicle.nsi.edu [online]. [cit. 12-11-2016]. Dostupné v archivu pořízeném dne 12-06-2009.

- PBS. THE BRAIN WITH DAVID EAGLEMAN | Brain Uploading | PBS. [s.l.]: [s.n.] Dostupné online.

- Hubert Dreyfus writes: "In general, by accepting the fundamental assumptions that the nervous system is part of the physical world and that all physical processes can be described in a mathematical formalism which can in turn be manipulated by a digital computer, one can arrive at the strong claim that the behavior which results from human 'information processing,' whether directly formalizable or not, can always be indirectly reproduced on a digital machine."

- Searle 1980, p. 7

- Searle writes "I like the straight forwardness of the claim."

- Dreyfus 1979, p. 156

- Haugeland 1985, p. 5

- Lucas 1961, Russell & Norvig 2003, pp. 949–950, Hofstadter 1979, pp. 471–473,476–477

- Graham Oppy (20 January 2015).

- Stuart J. Russell; Peter Norvig (2010). "26.1.2: Philosophical Foundations/Weak AI: Can Machines Act Intelligently?

- Mark Colyvan.

- Russell & Norvig 2003, p. 950.

- Hofstadter 1979

- According to Hofstadter 1979, pp. 476–477, this statement was first proposed by C. H. Whiteley

- Hofstadter 1979, pp. 476–477, Russell & Norvig 2003, p. 950, Turing 1950 under "The Argument from Mathematics" where he writes "although it is established that there are limitations to the powers of any particular machine, it has only been stated, without sort of proof, that no such limitations apply to the human intellect."

- Dreyfus 1972, Dreyfus 1979, Dreyfus & Dreyfus 1986.

- Russell & Norvig 2003, pp. 950–51

- Turing 1950 under "(8) The Argument from the Informality of Behavior"

- Turing 1950 under "(4) The Argument from Consciousness".

- Russell & Norvig 2003, p. 947

- Searle 1980.

- Searle 1980, p. 13

- Searle 1984

- HTTP://HELLDESIGN.NET. The Problem of AI Consciousness | KurzweilAI. www.kurzweilai.net [online]. [cit. 2017-01-17]. Dostupné online.

- Cole 2004, 2.1, Leibniz 1714, 17

- Cole 2004, 2.3

- Searle 1980 under "1.

- Cole 2004, 4.2 ascribes this position to Ned Block, Daniel Dennett, Tim Maudlin, David Chalmers, Steven Pinker, Patricia Churchland and others.

- Searle 1980 under "2.

- Quoted in Crevier 1993, p. 272

- Searle 1980 under "3.

- Searle 1980 under "5.

- Dreyfus 1979, p. 156, Haugeland 1985, pp. 15–44

- Horst 2005

- Turing 1950 under "(5) Arguments from Various Disabilities"

- Quoted in Crevier 1993, p. 266

- Reading facial expressions of emotion. http://www.apa.org [online]. [cit. 2016-11-20]. Dostupné online.

- Turing 1950 under "(6) Lady Lovelace's Objection"

- Turing 1950 under "(5) Argument from Various Disabilities"

- RITCHIE, G. D.; HANNA, F. K. AM: A case study in AI methodology. Artificial Intelligence. August 1984, s. 249–268. DOI 10.1016/0004-3702(84)90015-8. (anglicky).

- Katz, Leslie (2009-04-02).

- Scientists Worry Machines May Outsmart Man By JOHN MARKOFF, NY Times, July 26, 2009.

- The Coming Technological Singularity: How to Survive in the Post-Human Era, by Vernor Vinge, Department of Mathematical Sciences, San Diego State University, (c) 1993 by Vernor Vinge.

- Call for debate on killer robots, By Jason Palmer, Science and technology reporter, BBC News, 8/3/09.

- Science New Navy-funded Report Warns of War Robots Going "Terminator" Archivováno 28. 7. 2009 na Wayback Machine, by Jason Mick (Blog), dailytech.com, February 17, 2009.

- Navy report warns of robot uprising, suggests a strong moral compass, by Joseph L. Flatley engadget.com, Feb 18th 2009.

- HARRIS, Sam. Transcript of "Can we build AI without losing control over it?". TED [online]. [cit. 2016-11-20]. Dostupné online.

- Turing 1950 under "(1) The Theological Objection", although it should be noted that he also writes "I am not very impressed with theological arguments whatever they may be used to support"